Don’t miss out on Current in New Orleans, October 29-30th — save 30% with code PRM-WEB | Register today

Consacrez moins de temps au nettoyage des données, et plus de temps à l'ingénierie.

Utilisez un traitement et une gouvernance Shift Left pour maximiser le ROI de vos entrepôts de données. Améliorez la qualité des données à hauteur de 60 %, réduisez les coûts de calcul de 30 % et boostez la productivité de vos ingénieurs.

Shift Left : unifier les opérations et les analyses avec les produits de données

Lire l'e-book

Glassdoor adopte une approche Shift Left à l'échelle du pétaoctet

Lire l'article

Confluent Tableflow s'intègre au catalogue Snowflake Polaris

Lire l'articleTraitement et gouvernance shift left pour des économies décuplées.

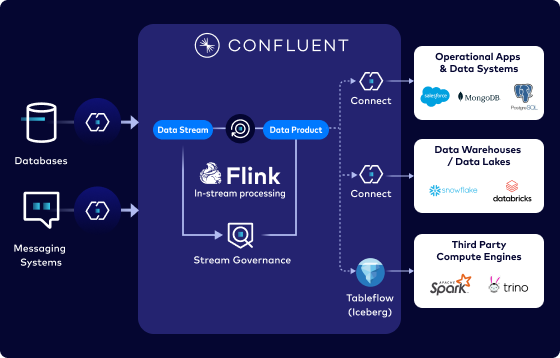

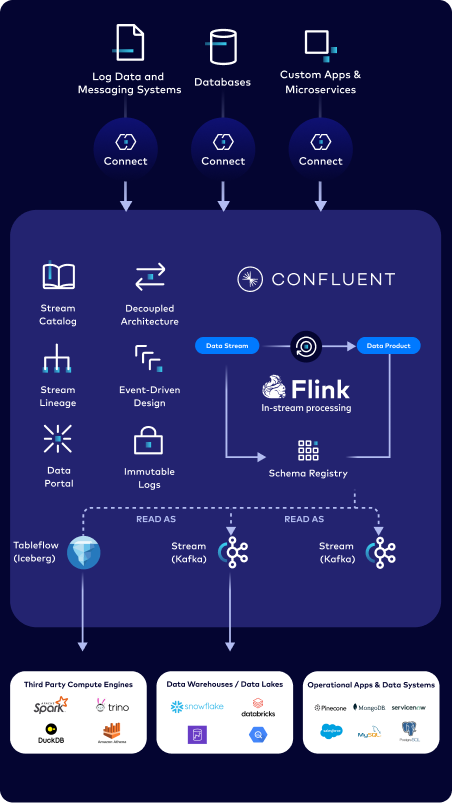

Alimentez vos analyses avec les données les plus récentes

Tirez parti de données fiables qui circulent, évoluent et sont traitées de manière continue grâce au streaming en temps réel et au traitement à la volée.

Fournissez des produits de données fiables et prêts à l'emploi

Adaptez les données à la volée à différents contextes tout en permettant la recherche et la découverte en libre-service.

Optimiser le ROI des entrepôts et des lacs de données

Optimisez le traitement et la gouvernance des données en réalisant ces processus une fois à la source. Réduisez de 40 à 60 % les problèmes liés à la qualité des données et libérez les ingénieurs concernés afin qu'ils puissent se consacrer à des tâches plus stratégiques.

Connexion et streaming instantanés à partir de vos systèmes opérationnels

Connecteurs prêts à l’emploi

Utilisez plus de 120 connecteurs self-managed et plus de 80 connecteurs zero-code et CDC entièrement gérés pour une connectivité instantanée aux systèmes de données existants.

Connecteurs personnalisés

Introduisez votre propre connecteur et exécutez-le en toute confiance et de manière économique sur notre service cloud entièrement géré.

Intégrations cloud native

Bénéficiez d'un accès instantané aux données de streaming directement dans AWS, Azure et GCP, sans jamais devoir quitter l'outil de votre choix.

Une conception solide, en une seule fois, pour gagner en productivité

Nettoyage à la source

Nettoyez, filtrez, combinez et enrichissez les flux à la volée pour favoriser une meilleure réutilisation des données

Traitement incrémentiel

Bénéficiez d'un traitement en continu et diffusez des vues de données mises à jour de manière incrémentale en quelques millisecondes seulement.

Prise en charge du traitement par lots et en temps réel

Utilisez une API unifiée prenant en charge le traitement des flux, le traitement par lots et l'analyse ad hoc

Développez dans votre language préféré

Programmez en Java, Python et SQL avec plus de 150 fonctions intégrées

Favorisez l'accès en libre-service à des produits de données fiables

Assurez la qualité des données à la source

Créez des produits de données fiables et de haute qualité avec des contrats de données explicites et une gestion des schémas

Découvrez des produits de données réutilisables

Aidez les consumers de données à rechercher et à réutiliser en toute sécurité des produits de données via le Data Portal

Unifiez le streaming et les analyses

Convertissez les topics Kafka et les schémas associés en tables Apache Iceberg en un clic avec Tableflow

« [Nettoyage des données] C’est un moyen coûteux de les faire parvenir jusqu'au Deltalake. La déduplication au sein de Confluent est plus avantageuse. Il nous suffit de le faire une seule fois. »

« J'adore cette vision [Shift Left]. C'est ainsi que nous pourrions rendre les ensembles de données plus faciles à découvrir. Je savais que Confluent offrait une intégration avec Alation, mais c'était vraiment top de voir que vous aviez d'autres moyens [Data Portal] de mettre en place ces fonctionnalités. »

Accélérez votre parcours avec Confluent et ses partenaires

Nous collaborons avec nos partenaires pour maximiser la valeur des produits de données de haute qualité dans l'ensemble de l'écosystème.