[Live Lab] Streaming 101: Hands-On with Kafka & Flink | Secure Your Spot

CAS D'USAGE| PIPELINES CDC

Création de pipelines CDC avec Apache Flink® sur Confluent

La capture des modifications de données (CDC) est utilisée pour copier des données dans des bases de données relationnelles, permettant ainsi des opérations de back-end essentielles telles que la synchronisation des données, la migration et la reprise après sinistre. Et maintenant, grâce à Stream Processing, vous pouvez créer des pipelines CDC qui alimentent des applications axées sur les événements et des produits de données fiables, avec des données actualisées, intégrées à travers des systèmes distribués, anciens et modernes.

Découvrez comment Confluent réunit Apache Kafka® et Apache Flink® pour que vous puissiez créer des pipelines CDC en continu et alimenter l'analyse en aval avec des données opérationnelles de haute qualité.

Passer de décisions prises sur des données obsolètes à des réactions en temps réel

Go from making decisions on stale data to reacting in real time

Réduisez vos coûts de traitement de 30 %

Reduce your processing costs by 30%

Fournissez des données fiables et propres sans intervention manuelle de dépannage

Deliver trusted, clean data without manual break-fix work

3 défis clésavec les architectures CDC traditionnelles

La plupart des organisations utilisent déjà le CDC basé sur les journaux pour transformer les modifications de la base de données en événements.

- Latence significative des données lors du traitement par lots. Au lieu des flux d'événements, la plupart des organisations s'appuient sur le traitement par lots pour matérialiser les données de logs en aval. Cela signifie que les systèmes de données restent désynchronisés pendant les heures ou les jours nécessaires pour que le processus de traitement par lots suivant s'exécute.

- Coûts du traitement redondant. Les coûts supplémentaires proviennent à la fois de la nécessité de construire et de maintenir des intégrations point à point, ainsi que du traitement redondant qui s'effectue à travers ces pipelines.

- Perte de confiance due à des cycles de correction manuels constants. Le maintien de l'exactitude de tous ces pipelines est chronophage et sujet à des erreurs humaines. Et cette approche contraint les équipes à réagir en résolvant les problèmes détectés uniquement lorsqu'ils affectent un autre consumer en aval.

La création de pipelines CDC avec Kafka et Flink vous permet d'unifier vos charges de travail CDC et vos analyses par lots, et d'éliminer les silos de traitement. Au lieu de dépendre du traitement par lots, d’assumer les coûts de traitements redondants ou de s’appuyer sur des pipelines peu robustes, cette architecture vous permet de :

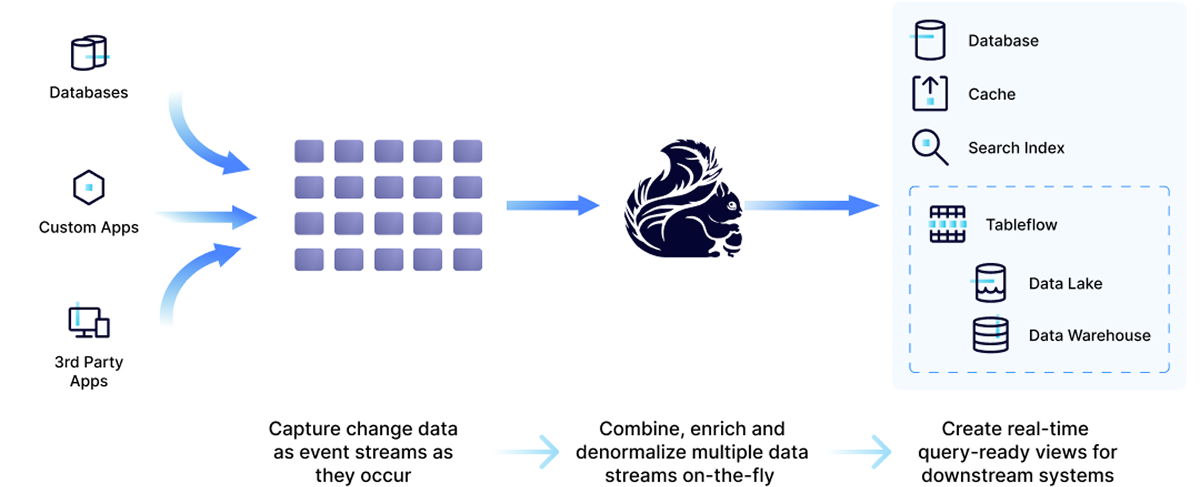

- Capturer des données CDC sous forme de flux d'événements

- Utiliser Flink pour traiter ces flux en temps réel

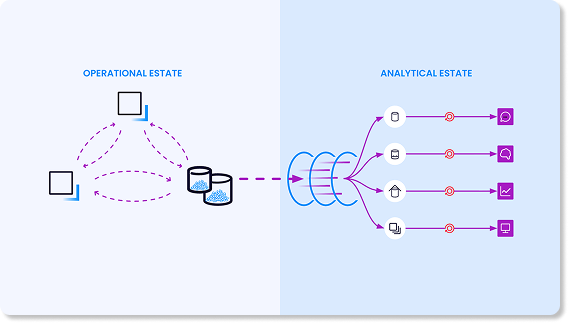

- Matérialiser instantanément les flux CDC sur l'ensemble de vos environnements opérationnels et analytiques.

Maximisez la valeur de vos données à une fraction du coût

Avec serverless Apache Flink® sur la plateforme de streaming de données Confluent , vous pouvez déplacer le traitement en amont — avant l'ingestion des données — pour améliorer la latence, la portabilité des données et la rentabilité.

- Enrichissement des données : Améliorez les données avec un contexte supplémentaire pour une précision accrue.

- Réutilisabilité des données : Partagez des flux de données cohérents entre les applications.

- En temps réel disponible partout : Activez des applications à faible latence pour qu'elles réagissent instantanément aux événements.

- Réduction des coûts : Optimisez l'utilisation des ressources et réduisez les traitements redondants.

Les équipes AppDev peuvent construire des pipelines de données qui permettent des actions en temps opportun

Qu’il s’agisse d’ingestion shift-left vers l'entrepôt de données et le lac de données pour l’analytique, de la création d’index de recherche en temps réel, de pipelines ML ou de l’optimisation des SIEM.

Les équipes d'analyse peuvent préparer et structurer des données pour alimenter des applications axées sur les événements en déclenchant des calculs, des mises à jour d'état ou des actions externes

Cela inclut des applications développées pour les solutions GenAI, la détection de fraude, les alertes et notifications en temps réel, la personnalisation du marketing, et plus encore.

3 étapes pour créer des pipelines CDC avec Confluent Stream Processing

Avec Confluent, vous pouvez traiter vos flux CDC avant de les matérialiser dans votre environnement analytique. Filtrez, fusionnez et enrichissez simplement les données CDC capturées dans vos topics Kafka avec Flink SQ. Ensuite, matérialisez les flux de données au sein de votre domaine opérationnel et analytique.

Démonstrations et études de cas CDC en streaming

Les clients de Confluent utilisent Flink pour améliorer les cas d'usage existants de la capture de données de changement (CDC), tels que la synchronisation des données et la reprise après sinistre, et pour débloquer de nouvelles capacités en temps réel.

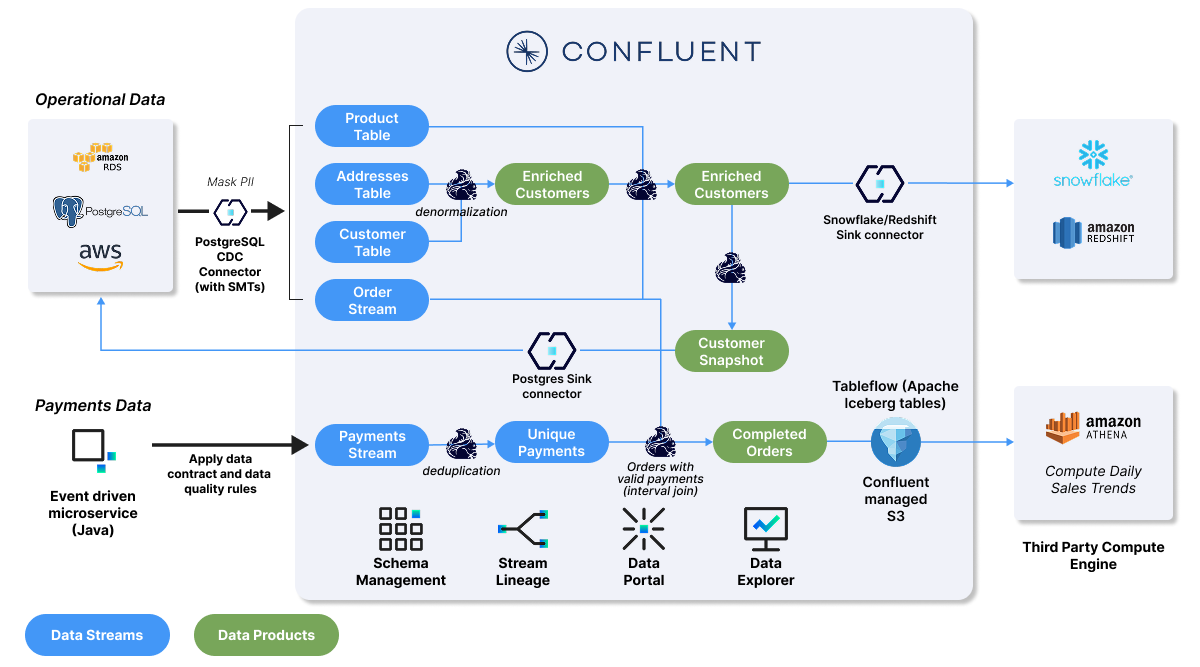

Explorez le dépôt GitHub pour apprendre à implémenter l’analytique en temps réel pour les cas d’usage Customer 360, l’analyse des ventes de produits ou l’analyse des tendances de vente.

Vous aurez 2 laboratoires parmi lesquels choisir :

Laboratoire d'agrégation des ventes de produits et de Customer360

Nettoyez et agrégez les données de vente des produits, ingérez les données enrichies dans Snowflake ou Redshift, puis créez un produit de données destiné aux bases de données opérationnelles.

Laboratoire des tendances de ventes quotidiennes

Validez les paiements, analysez les modèles de vente pour identifier les tendances quotidiennes, puis matérialisez le topic Kafka sous forme de table Iceberg dans Amazon Athena pour obtenir des informations plus approfondies.

« L’adoption de CDC nous a permis de libérer la puissance des données en temps réel, ce qui nous a fait passer du traitement par lots au traitement des flux. »

« Avec Flink, nous avons maintenant la possibilité de passer au shift left et d'effectuer de nombreuses transformations et calculs en amont sur nos données avant qu'elles n'atteignent Snowflake. » Cela optimisera nos coûts de traitement des données afin d'augmenter la quantité de données dont nous disposons.

« Grâce à Confluent, nous pouvons désormais facilement créer les pipelines de capture des modifications de données (CDC) dont nous avons besoin pour acquérir des données en temps réel plutôt que de les récupérer par lots toutes les 10 minutes, ce qui nous permet de détecter les fraudes rapidement. »

« Le plus difficile, c'est que nous n'avions pas assez de ressources internes pour développer CDC et le processus de streaming. Maintenant, nous pouvons facilement créer des systèmes CDC… L'équipe de développeurs a réussi à réduire sa charge de travail tout en développant le processus de streaming.

« Grâce à Confluent Cloud, nous pouvons désormais fournir des données opérationnelles en temps réel aux équipes qui en ont besoin. Il s’agit d’une réelle avancée, qui réduit considérablement notre charge opérationnelle. »

Êtes-vous prêt à commencer à traiter les données CDC en temps réel avec Flink ? Commencez à utiliser Confluent et implémentez une architecture de traitement des flux adaptée à tous les environnements.

Essayez Confluent Cloud pour Apache Flink®—disponible sur AWS, Google Cloud, Microsoft Azure—pour créer des applications exploitant Kafka + Flink avec une efficacité et une simplicité de coût sans serveur et cloud-native.

Et avec Confluent Platform pour Apache Flink®, vous pouvez transférer vos charges de travail Flink existantes vers une plateforme de streaming de données self-managed, prête à être déployée sur site ou dans votre Cloud privé.

Confluent Cloud

Un service cloud native entièrement géré basé sur Apache Kafka®

Streaming CDC With Flink | FAQs

How does a streaming approach improve on batch ELT/ETL pipelines?

A streaming approach allows you to "shift left," processing and governing data closer to the source. Instead of running separate, costly ELT jobs in multiple downstream systems, you process the data once in-stream with Flink to create a single, reusable, high-quality data product. This improves data quality, reduces overall processing costs and risks, and gets trustworthy data to your teams faster.

Why use Apache Flink® for processing real-time CDC Data?

Apache Flink® is the de facto standard for stateful stream processing, designed for high-performance, low-latency workloads—making it ideal for CDC. Its ability to handle stateful computations allows it to accurately interpret streams of inserts, updates, and deletes to maintain a correct, materialized view of data over time. Confluent offers a fully managed, serverless Flink service that removes the operational burden of self-management.

How do you handle data consistency and quality in real-time CDC pipeline?

Data consistency is maintained by processing CDC events in-flight to filter duplicates, join streams for enrichment, and aggregate data correctly before it reaches any downstream system. Confluent's platform integrates Flink with Stream Governance, including Schema Registry, to define and enforce universal data standards, ensuring data compatibility, quality, and lineage tracking across your organization.

How does Confluent Cloud handle changes to the source database schema?

When your CDC pipeline is integrated with Confluent Schema Registry, it can automatically and safely handle schema evolution. This ensures that changes to the source table structure—like adding or removing columns—do not break downstream applications or data integrity. The platform manages schema compatibility, allowing your data streams to evolve seamlessly.

What are the main benefits of using a Fully managed service for Apache Flink® like Confluent Cloud?

A fully managed service eliminates the significant operational complexity, steep learning curve, and high in-house support costs associated with self-managing Apache Flink®. With Confluent, you get a serverless experience with elastic scalability, automated updates, and pay-as-you-go pricing, allowing your developers to focus on building applications rather than managing infrastructure. In addition, native integration between Apache Kafka® and Apache Flink® and pre-built connectors allow teams to build and scale fast.

How does Confluent Cloud simplify processing Debezium CDC events?

Confluent Cloud provides first-class support for Debezium, an open source distributed platform for change data capture. Pre-built connectors can automatically interpret the complex structure of Debezium CDC event streams, simplifying the process of integrating with Kafka and Flink.