[Webinar] From Fire Drills to Zero-Loss Resilience | Register Now

STREAM GOVERNANCE DE NIVEAU ENTREPRISE

Découvrez, comprenez et exploitez vos données en toute confiance

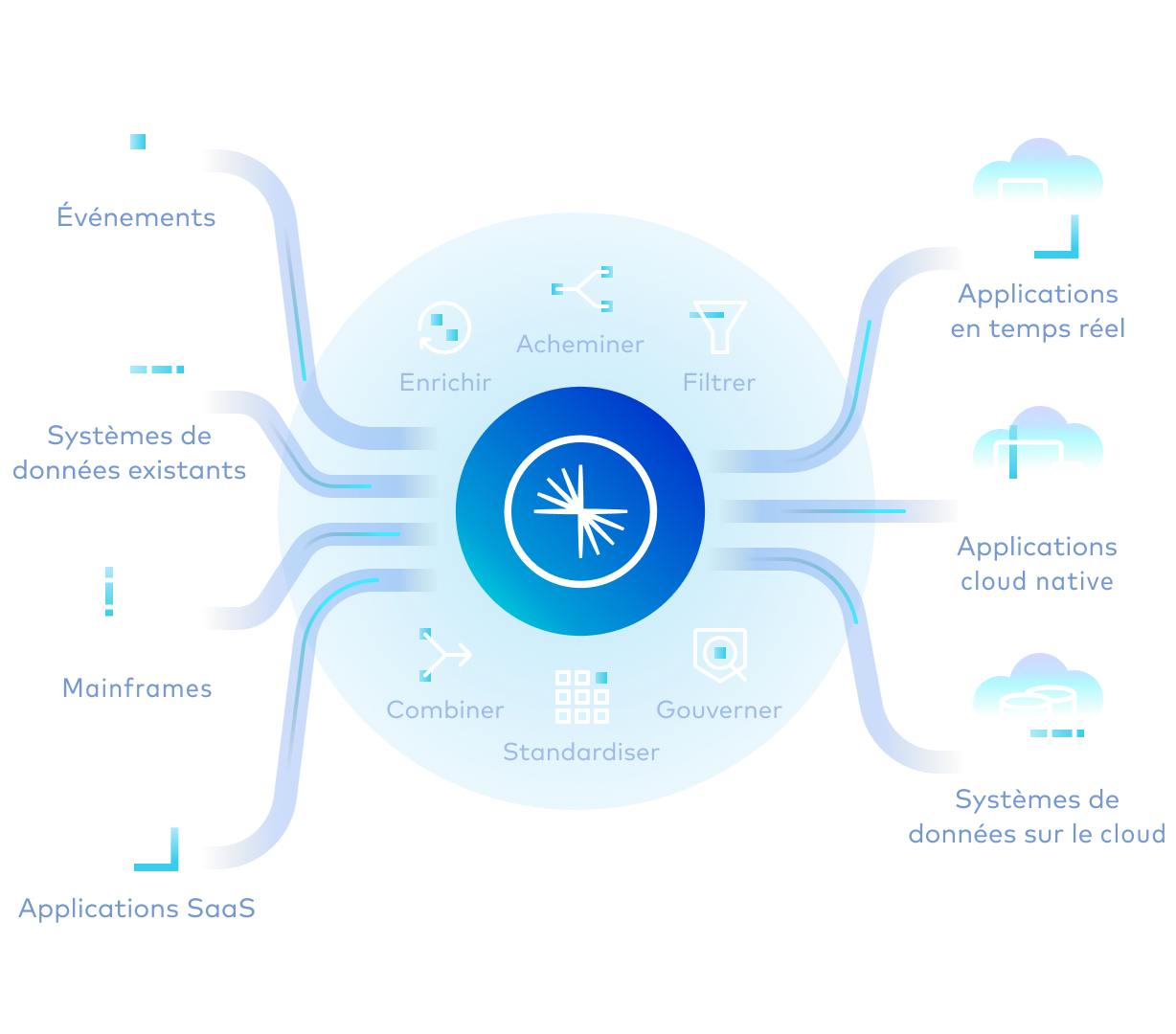

Stream Governance offre une visibilité et un contrôle sur la structure, la qualité et le flux des données à travers vos applications, vos analyses et votre intelligence artificielle.

Acertus réduit le coût total de possession et garantit la qualité des données

Vimeo crée des produits de données en quelques heures, plutôt qu'en plusieurs jours ou semaines

SecurityScorecard protège les données qui comptent le plus

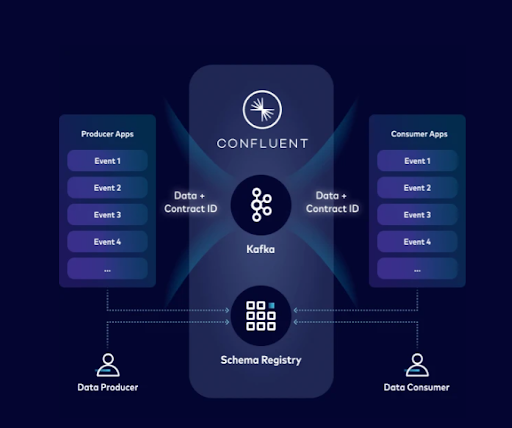

Stream Governance unifie la qualité, la découverte et le lignage des données. Vous pouvez créer des produits de données en temps réel en définissant une seule fois les contrats de données et en les appliquant dès la création des données, plutôt qu’après leur traitement en lots.

Comment protéger les informations personnelles identifiables (PII) dans Apache Kafka® avec Schema Registry et les contrats de données

Découvrez comment sécuriser les données sensibles

Assurez la qualité des données à la source, et non après leur traitement par lots

Stream Quality empêche les données incorrectes d'entrer dans le flux de données.

Il gère et fait respecter les contrats de données — schéma, métadonnées et règles de qualité — entre producers et consumers au sein de votre réseau privé avec :

Schema registry

Définissez et appliquez des normes universelles pour tous vos topics de streaming de données dans un référentiel versionné.

Contrats de données

Appliquez des règles sémantiques et une logique métier à vos flux de données

Schema Validation

Les brokers vérifient que les messages utilisent des schémas valides lorsqu'ils sont affectés à un topic spécifique

Liaison de schémas

Synchronisez les schémas sur les environnements cloud et hybrides en temps réel

Client-Side Field Level Encryption (CSFLE)

Protégez vos données les plus sensibles en chiffrant des champs spécifiques dans les messages au niveau du client

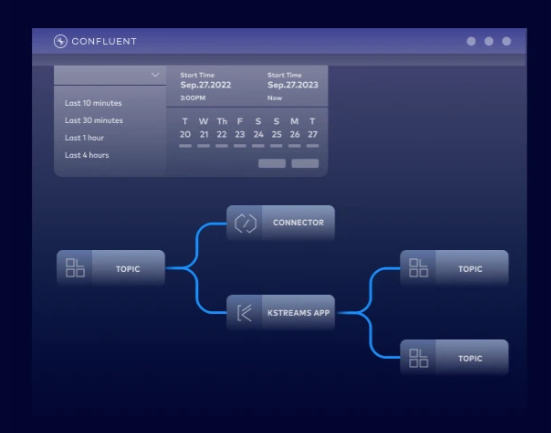

Surveillez les flux de données et résolvez les problèmes en quelques minutes

Un nombre quelconque de producers de données peuvent écrire des événements dans un journal partagé, et un nombre quelconque de consumers peuvent lire ces événements indépendamment et en parallèle. Vous pouvez ajouter, faire évoluer, récupérer et mettre à l'échelle des producers ou des consumers, sans dépendances.

Confluent intègre vos systèmes existants et modernes :

Bibliothèques de clients

Déployez une application client d'exemple en quelques minutes en utilisant la langue de votre choix.

Connecteurs préconfigurés

Évitez de consacrer 3 à 6 mois à la conception, à la création et aux tests de chaque connecteur.

Connecteurs personnalisés

Créez vos propres intégrations et laissez-nous gérer l'infrastructure Connect

Accélérez le délai de mise sur le marché grâce à l'accès en libre-service

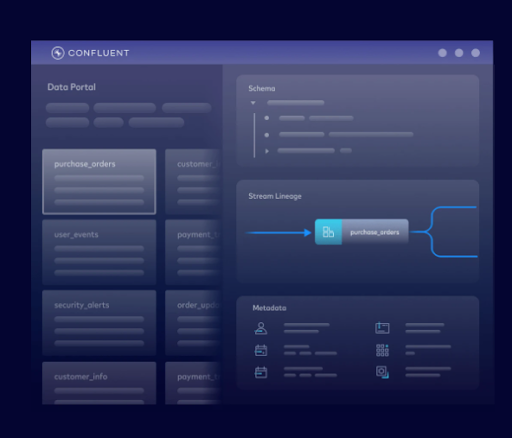

Stream Catalog organise les topics de streaming de données en tant que produits de données accessibles à tout système opérationnel, analytique ou d'IA.

Balisage des métadonnées

Enrichissez les topics avec des informations commerciales sur les équipes, les services, les cas d'usage, les systèmes, et plus encore.

Portail de données

Permettez aux utilisateurs finaux de rechercher, d'interroger, de découvrir, de demander l'accès et de visualiser chaque produit de données via une interface utilisateur.

Enrichissement des données

Consommez et enrichissez des flux de données, exécutez des requêtes et créez des pipelines de données de streaming directement dans l'interface utilisateur

Accès programmatique

Recherchez, créez et marquez des topics via une API REST basée sur Apache Atlas et une API GraphQL

Pérennisez vos données pour tout environnement ou toute architecture

Vous pouvez répondre aux exigences changeantes de l'entreprise sans perturber les charges de travail en aval pour les applications, l'analyse ou l'IA avec les fonctionnalités suivantes :

Évolution de schéma en toute sécurité

Ajoutez de nouveaux champs, modifiez les structures de données ou mettez à jour les formats tout en maintenant la compatibilité avec les tableaux de bord, les rapports et les modèles ML existants

Vérification automatisée de la compatibilité

Validez les modifications de schéma avant le déploiement pour éviter de perturber les applications analytiques en aval et les pipelines d'IA.

Chemins de migration flexibles

Choisissez les modes de compatibilité rétroactive, proactive ou complète en fonction de vos besoins spécifiques de mise à niveau et de vos contraintes organisationnelles.

ACERTUS utilise le Schema Registry pour simplifier la modification et l’extension des contrats de commande, sans avoir à toucher au code existant. Les modifications apportées aux schémas et aux données des sujets sont enregistrées instantanément. Ainsi, lorsque les utilisateurs de données trouvent les données qu'ils recherchent, ils peuvent être assurés de leur exactitude et de leur fiabilité.

Confluent garantit la qualité et la sécurité des données avec Stream Governance, et permet à Vimeo de faire évoluer et de partager en toute sécurité ses produits de données à l'échelle de son entreprise.

« Il est étonnant de réaliser tout ce que nous sommes capables d’accomplir lorsque nous n'avons pas à nous soucier de la manière exacte de procéder. Nous pouvons faire confiance à Confluent pour proposer une plateforme Kafka sécurisée et robuste dotée d'une myriade de fonctionnalités à valeur ajoutée, telles que la sécurité, les connecteurs et la gouvernance des données. »

Les nouveaux développeurs reçoivent 400 $ de crédits à dépenser pendant leurs 30 premiers jours, sans avoir à passer par un représentant commercial.

Confluent vous offre les outils et ressources nécessaires pour :

- Construire : tirez parti de bibliothèques clientes pour des langages comme Java et Python, des exemples de code, plus de 120 connecteurs préconfigurés et une extension Visual Studio Code.

- Apprendre : profitez d'un accès à des cours à la demande, des certifications et une communauté mondiale d'experts.

- Exploiter : bénéficiez d'une CLI, de la prise en charge de l'IaC pour Terraform et Pulumi, et de l'observabilité OpenTelemetry.

Vous pouvez vous inscrire directement avec nous ou avec votre compte cloud marketplace ci-dessous.

Confluent Cloud

Un service cloud native entièrement géré basé sur Apache Kafka®

Ressources de Stream Governance

Stream Governance With Confluent | FAQS

What is Stream Governance?

Stream Governance is a suite of fully managed tools that help you ensure data quality, discover data, and securely share data streams. It includes components like Schema Registry for data contracts, Stream Catalog for data discovery, and Stream Lineage for visualizing data flows.

Why is Stream Governance important for Apache Kafka?

As Kafka usage scales, managing thousands of topics and ensuring data quality becomes a major challenge. Governance provides the necessary guardrails to prevent data chaos, ensuring that the data flowing through Kafka is trustworthy, discoverable, and secure. This makes it possible to democratize data access safely.

What components are included in Confluent’s Stream Governance?

While open source provides basic components like Schema Registry, Confluent offers a complete, fully managed, and integrated suite. Stream Governance combines data quality, catalog, and lineage into a single solution that is deeply integrated with the Confluent Cloud platform, including advanced features like a Data Portal, graphical lineage, and enterprise-grade SLAs.

How is Confluent’s approach different from open source Kafka governance?

Yes. Confluent Schema Registry supports Avro, Protobuf, and JSON Schema, giving you the flexibility to use the data formats that best suit your needs.

Does Stream Governance support industry standards like Avro and Protobuf?

Yes, Confluent Stream Governance provides robust support for industry-standard data serialization formats through its integrated Schema Registry.

Schema Registry centrally stores and manages schemas for your Kafka topics, supporting the following formats: Apache Avro, Protobuf, JSON Schema.

This ensures that all data produced to a Kafka topic adheres to a predefined structure. When a producer sends a message, it serializes the data according to the registered schema, which typically converts it into a compact binary format and embeds a unique schema ID. When a consumer reads the message, it uses that ID to retrieve the correct schema from the registry and accurately deserialize the data back into a structured format. This process not only enforces data quality and consistency but also enables safe schema evolution over time.

Can I use Stream Governance on-premises?

The complete Stream Governance suite, including the Data Portal and interactive Stream Lineage, is exclusive to Confluent Cloud. However, core components like Schema Registry are available as part of the self-managed Confluent Platform.

Is Stream Governance suitable for regulated industries?

Yes. Stream Governance is suitable for regulated industries and provides the tools you need to ensure data security and compliance with industry and regional regulations. Its Stream Lineage features help with audits, allowing you to use schema enforcement and data quality rules to ensure data integrity. Across the fully managed data streaming platform, Confluent Cloud also holds numerous industry certifications like PCI, HIPAA, and SOC 2.

How can I get started with Stream Governance?

You can get started with Stream Governance by signing up for a free trial of Confluent Cloud. New users receive $400 in cloud credit to apply to any of the data streaming, integration, governance, and stream processing capabilities on the data streaming platform, allowing you try Stream Governance features firsthand.

We also recommended exploring key Stream Governance concepts in Confluent documentation, as well as following the Confluent Cloud Quick Start, which takes you through how to deploy your first cluster, product and consume messages, and inspect them with Stream Lineage.